ollama在linux中的安装与卸载

1、快速安装

Ollama 下载:https://ollama.com/download/linux

Ollama 官方主页:https://ollama.com

Ollama 官方 GitHub 源代码仓库:https://github.com/ollama/ollama/

直接使用官方的linux指令

curl -fsSL https://ollama.com/install.sh | sh此命令将自动下载最新版本的 Ollama 并完成安装,以下是 Ollama 使用常见的指令:

ollama serve #启动ollama

ollama create #从模型文件创建模型

ollama show #显示模型信息

ollama run #运行模型

ollama pull #从注册表中拉取模型

ollama push #将模型推送到注册表

ollama list #列出模型

ollama cp #复制模型

ollama rm #删除模型

ollama help #获取有关任何命令的帮助信息

1.1 启动ollama

ollama serve

1.2 拉取你自己需要部署的大模型

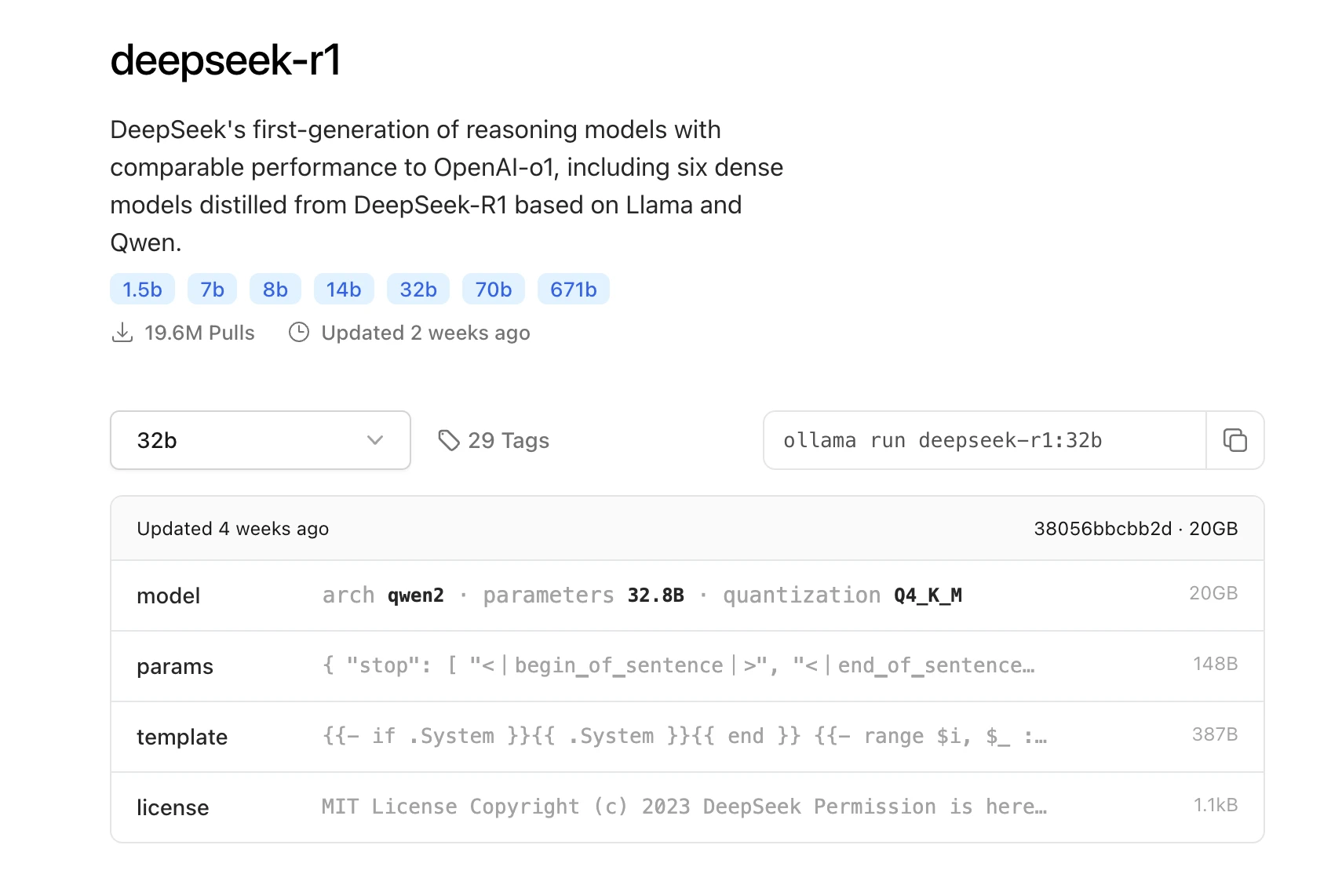

下方仅是示例,去ollama官网去找自己需要的模型

ollama run deepseek-r1:14b #拉取deepseek-r1 14b参数的大模型

ollama run deepseek-r1:32b #拉取deepseek-r1 14b参数的大模型

2、加速安装

由于网络环境的原因,往往使用方法一会存在安装失败的情况,此时我们就需要借助加速源进行加速下载,操作步骤如下

2.1 下载并修改安装脚本

# 下载安装脚本

curl -fsSL https://ollama.com/install.sh -o ollama_install.sh

# 给脚本添加执行权限

chmod +x ollama_install.sh

2.2 下载系统系统架构的下载源

这里以x86架构的linux为例

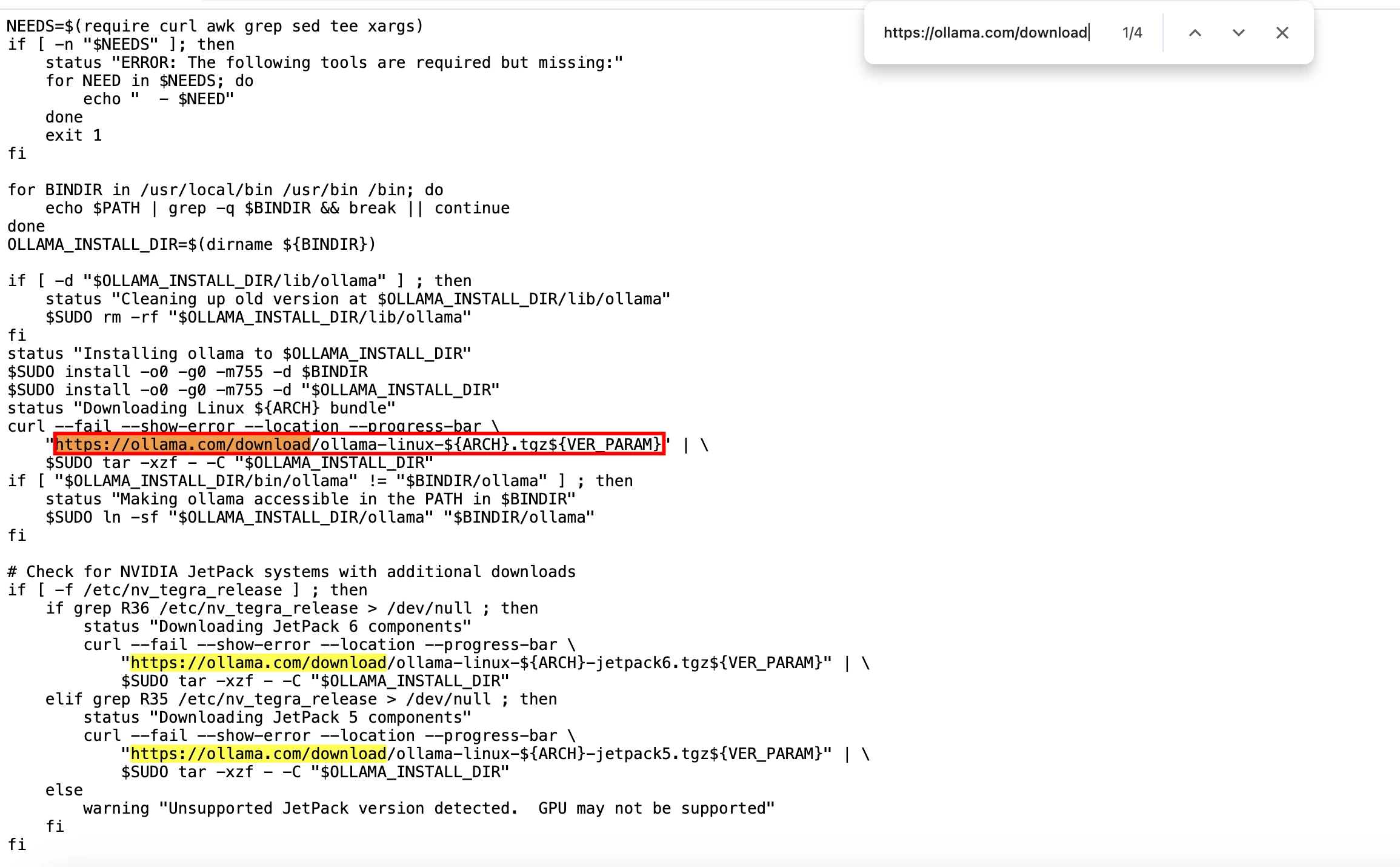

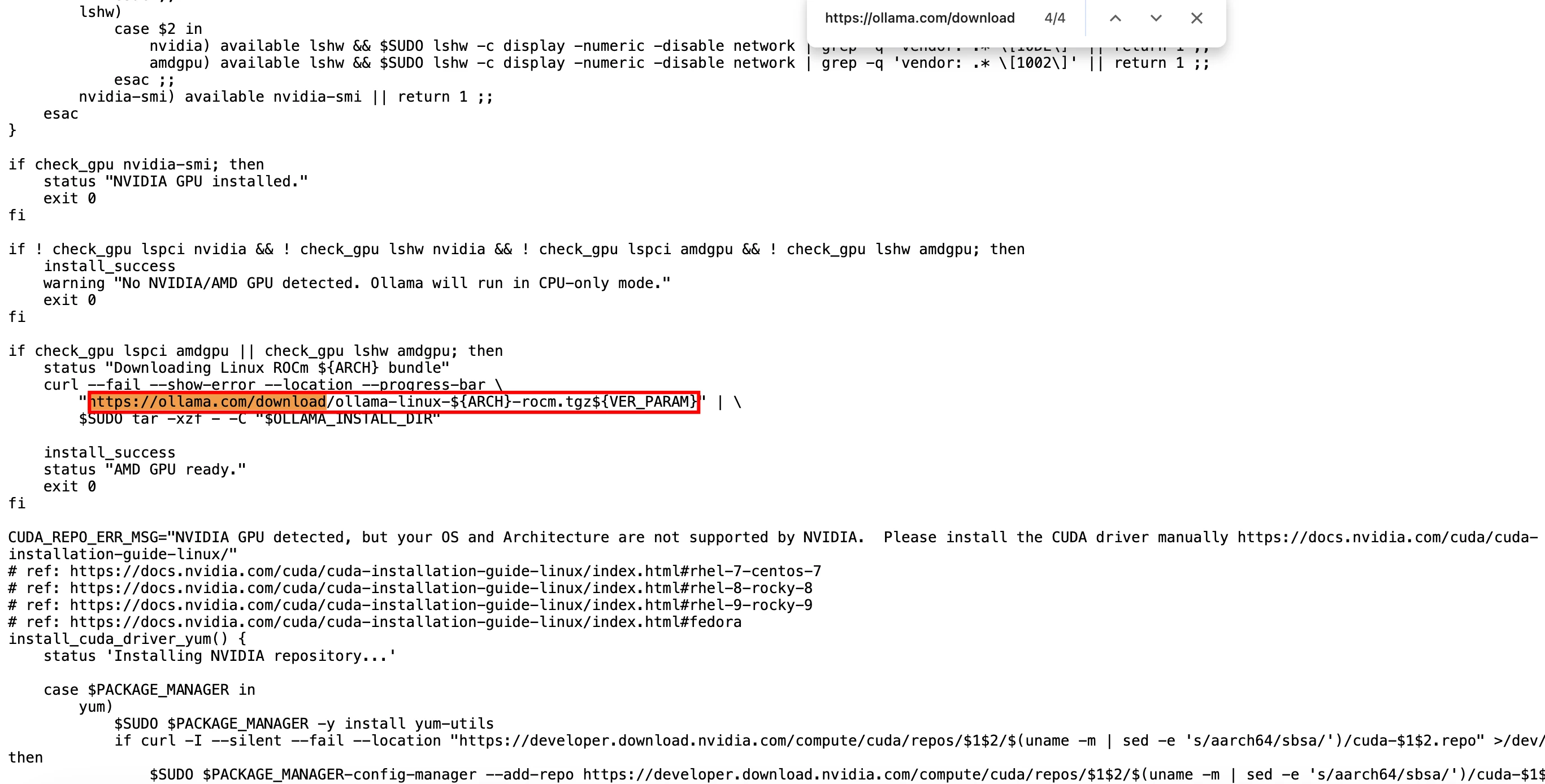

打开ollama_install.sh,找到以下两个下载地址

https://ollama.com/download/ollama-linux-${ARCH}${VER_PARAM}

https://ollama.com/download/ollama-linux-amd64-rocm.tgz${VER_PARAM}

我们要把这两个地址替换成GitHub的下载链接

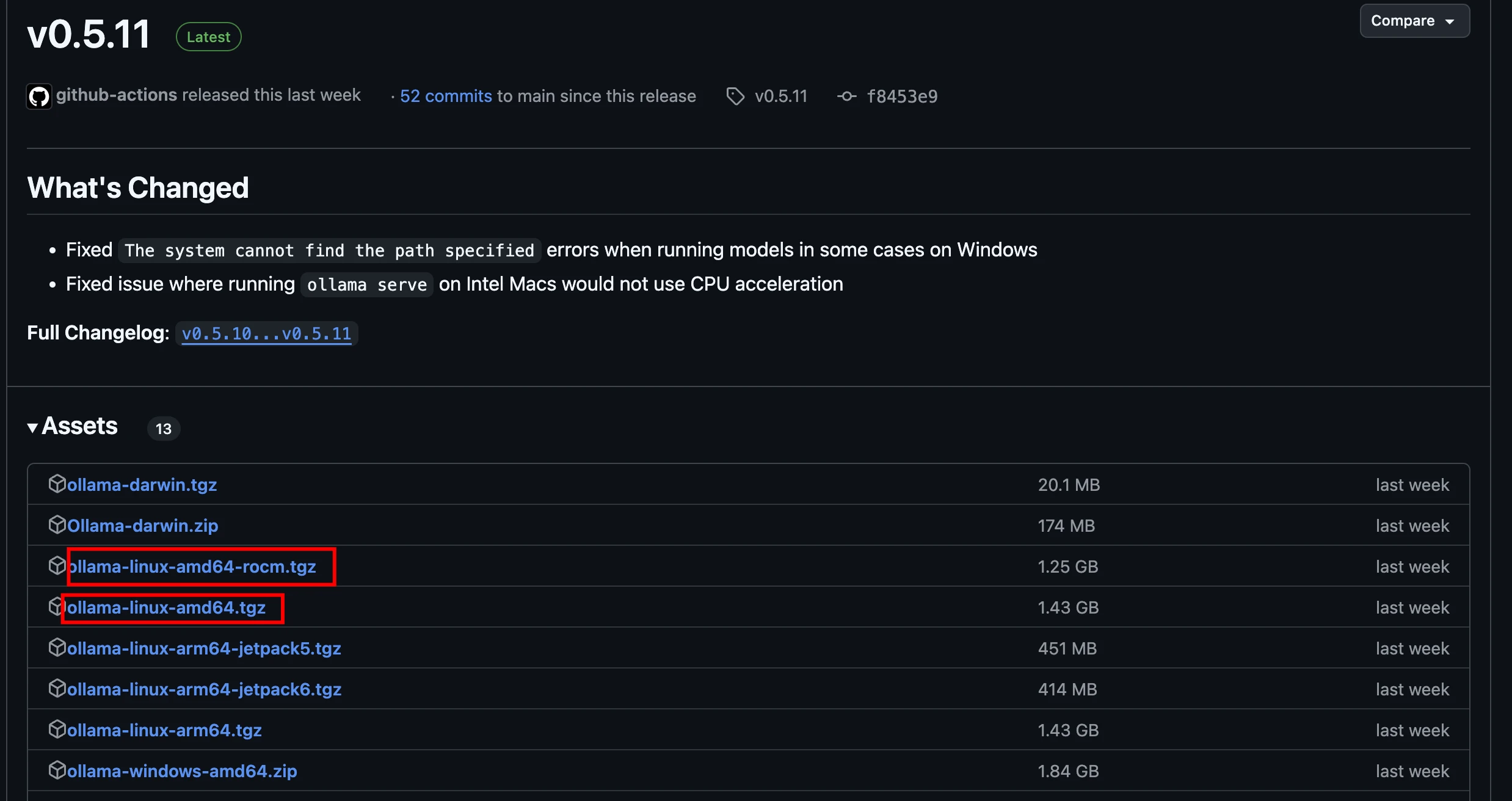

打开ollama项目的github地址,选择如图所示的链接地址

但是直接用GitHub可能还是很慢,所以我们最好使用github加速源进行代理加速

示例:

#地址一

https://github.moeyy.xyz/https://github.com/ollama/ollama/releases/download/v0.5.11/ollama-linux-amd64.tgz

#地址二

https://github.moeyy.xyz/https://github.com/ollama/ollama/releases/download/v0.5.11/ollama-linux-amd64-rocm.tgz

2.3 运行修改后的脚本

sudo ./ollama_install.sh

3、手动安装

3.1 下载二进制文件ollama

将 Ollama 的二进制文件下载到 PATH 中的目录:

sudo curl -L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollama

sudo chmod +x /usr/bin/ollama

3.2 将 Ollama 添加为自启动服务

首先,为 Ollama 创建用户:

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama

然后在该位置:/etc/systemd/system/ollama.service 创建服务文件

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

[Install]

WantedBy=default.target

最后启动服务:

sudo systemctl daemon-reload

sudo systemctl enable ollama

3.3 启动 Ollama

使用以下命令启动 Ollama:systemd

sudo systemctl start ollama

3.4 Ollama允许通过localhost以外的IP访问

编辑服务文件 /etc/systemd/system/ollama.service

在 [Service] 下增加两个环境变量

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

之后

systemctl daemon-reload

systemctl restart ollama

重启ollama服务

4、更新ollama

再次运行之前的安装语句来更新 Ollama:

curl -fsSL https://ollama.com/install.sh | sh

或者下载 Ollama 二进制文件:

sudo curl -L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollama

sudo chmod +x /usr/bin/ollama

5、查看日志

journalctl -u ollama #查看日志

service ollama status #查看状态

6、卸载

6.1 删除 Ollama 服务

sudo systemctl stop ollama

sudo systemctl disable ollama

sudo rm /etc/systemd/system/ollama.service

6.2 从 bin 目录中删除 Ollama 二进制文件: /usr/local/bin,/usr/bin ,/bin

sudo rm $(which ollama)

6.3 删除下载的模型和 Ollama 服务用户和组

sudo rm -r /usr/share/ollama

sudo userdel ollama

sudo groupdel ollama

7、常见问题

7.1 ollama环境变量设置

1. OLLAMA_HOST:这个变量定义了Ollama监听的网络接口。通过设置OLLAMA_HOST=0.0.0.0,我们可以让Ollama监听所有可用的网络接口,从而允许外部网络访问。

2. OLLAMA_MODELS:这个变量指定了模型镜像的存储路径。通过设置OLLAMA_MODELS=F:\OllamaCache,我们可以将模型镜像存储在E盘,避免C盘空间不足的问题。

3. OLLAMA_KEEP_ALIVE:这个变量控制模型在内存中的存活时间。设置OLLAMA_KEEP_ALIVE=24h可以让模型在内存中保持24小时,提高访问速度。

4. OLLAMA_PORT:这个变量允许我们更改Ollama的默认端口。例如,设置OLLAMA_PORT=8080可以将服务端口从默认的11434更改为8080。

5. OLLAMA_NUM_PARALLEL:这个变量决定了Ollama可以同时处理的用户请求数量。设置OLLAMA_NUM_PARALLEL=4可以让Ollama同时处理两个并发请求。

6. OLLAMA_MAX_LOADED_MODELS:这个变量限制了Ollama可以同时加载的模型数量。设置OLLAMA_MAX_LOADED_MODELS=4可以确保系统资源得到合理分配。

7. OLLAMA_ORIGINS: 允许的源列表,星号*或使用逗号分隔。

7.2 ollama常驻内存

在 /etc/systemd/system/ollama.service 中加入

Environment="OLLAMA_KEEP_ALIVE=-1"修改后执行命令:

sudo systemctl daemon-reload

sudo systemctl enable ollama

版权声明:

作者:zhanghang

链接:https://www.sunnyboys.cn/ollama%e5%9c%a8linux%e4%b8%ad%e7%9a%84%e5%ae%89%e8%a3%85%e4%b8%8e%e5%8d%b8%e8%bd%bd.html

文章版权归作者所有,未经允许请勿转载。

THE END